Como hemos podido observar antes en nuestros artículos sobre deepfakes, los cuales son plataformas de Inteligencia Artificial capaces de modificar o crear imágenes, fotos, vídeos e incluso textos completos, partiendo de una base o incluso desde cero, utilizando la pseudocreatividad de la IA. Esto genera cierta preocupación al pensar que complica distinguir la verdad de la mentira, complicando la situación.

Esto genera un problema para las personas, dado que puede ocasionar malentendidos de diferentes escalas, como una broma de mal gusto o hasta problemas legales. Por lo cual, los mismos creadores y responsables de sus creaciones han decidido responder, aplicando la frase del título, la cual se refiere que utilizarán Inteligencia Artificial para detectar las creaciones de otras plataformas, desafiando la capacidad de cada uno, tanto el que genera como el que detecta.

Son los investigadores de la Universidad de Harvard y el MIT-IBM Watson AI Lab quienes han desarrollado una nueva herramienta para detectar texto que se ha generado utilizando AI llamado Giant Language Model Test Room (GLTR), este explota el hecho de que los generadores de texto IA dependen de patrones estadísticos en el texto, en oposición al significado real de las palabras y oraciones. En otras palabras, la herramienta puede determinar si las palabras que está leyendo parecen demasiado predecibles para haber sido escritas por una mano humana.

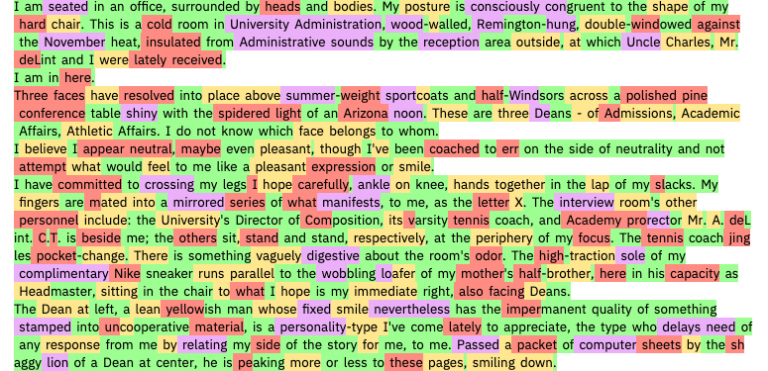

GLTR resalta las palabras que son estadísticamente probables de aparecer después de la palabra anterior en el texto. Como se muestra en el pasaje anterior (de Infinite Jest), las palabras más predecibles son verdes; menos predecibles son el amarillo y el rojo; y los menos predecibles son morados. Cuando se prueba en fragmentos de texto escritos por el algoritmo de OpenAI, encuentra mucha previsibilidad. Los artículos de noticias genuinos y los resúmenes científicos contienen más sorpresas.

Los investigadores detrás de GLTR también llevaron a cabo otro experimento. Pidieron a los estudiantes de Harvard que identificaran el texto generado por IA, primero sin la herramienta y luego con la ayuda de su resaltado. Los estudiantes pudieron detectar solo la mitad de todas las falsificaciones por su cuenta, pero el 72% cuando recibieron la herramienta.

“Nuestro objetivo es crear sistemas de colaboración humanos y de inteligencia artificial”, dice Sebastian Gehrmann, un estudiante de doctorado involucrado en el trabajo.

Si se piensa, estamos presenciando una de las primeras batallas IA de nuestra generación, estando en juego la realidad.